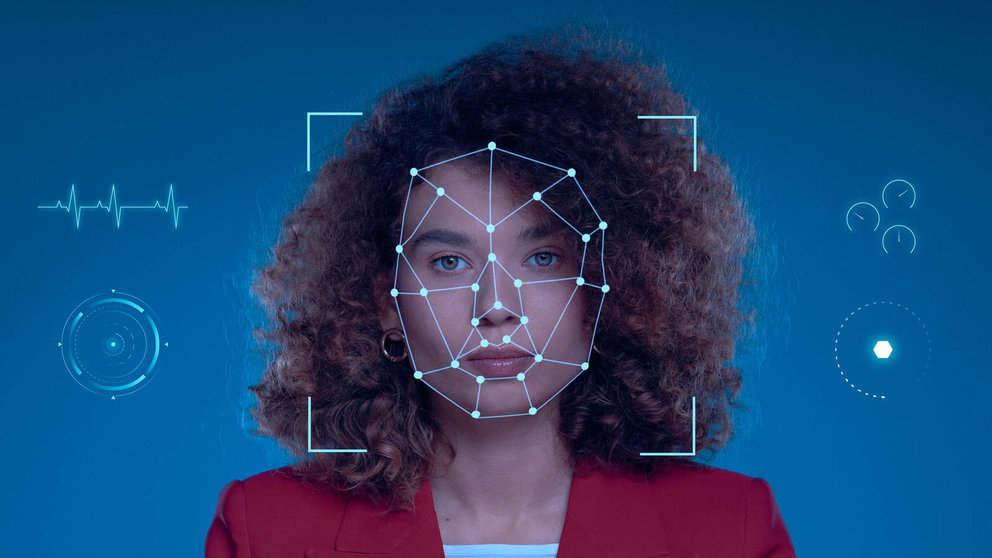

Desde hace unos años los deepfakes están en todas las mesas de actualidad. Esta técnica de la inteligencia artificial que da vida a imágenes o vídeos falsos se ha convertido en un debate para la sociedad debido a que su resultado es cada vez más real. Dicha práctica ha causado una gran ola de delincuentes que utilizan esta tecnología para replicar el aspecto, la voz y los movimientos de una persona con el objetivo de estafar. De hecho, según el informe Get identity fraud report 2023, los incidentes globales de fraude con deepfakes se multiplicaron por diez entre 2022 y 2023. Por ello, desenmascarar esta práctica se ha convertido en todo un reto en este 2024.

La tecnología que persigue esta práctica es cada vez mayor, como el desarrollo de herramientas avanzadas de detección, así como también está aumentando la educación de la ciudadanía sobre este tipo de manipulaciones y el fortalecimiento de las leyes y regulaciones contra los deepfakes. Sin embargo, al mismo tiempo, las empresas y los individuos deben estar alerta y desarrollar métodos de verificación adicionales para confirmar la autenticidad de la información, especialmente cuando se trata de decisiones financieras o de alto riesgo.

"Desenmascarar los deepfakes es un esfuerzo multifacético que requiere tecnología avanzada, educación pública y colaboración global. En 2024, con el auge de la inteligencia artificial, estas medidas son más importantes que nunca para combatir el fraude y proteger la integridad de la información", afirma Pierre Marra, Country Manager de España en Fourthline. Además, la empresa de verificaciones de identidad destaca cinco prácticas a seguir para combatir a los delincuentes:

- Utilizar modelos entrenados con datos KYC: una parte significativa de los modelos de reconocimiento facial utilizados en el mercado no están entrenados con datos de "Conozca a su cliente" (KYC), que proceden directamente de presentaciones de clientes del mundo real durante los procesos de verificación de identidad. La mayoría de los proveedores entrenan sus algoritmos con datos genéricos, como imágenes de archivo, fotos de famosos, datos públicos o datos de vigilancia. Sin embargo, este material de partida no responde a las necesidades específicas de la verificación de identidad y no puede ofrecer el nivel de precisión requerido.

- Herramientas de análisis forense digital: estas herramientas pueden analizar metadatos y características de los archivos de medios para detectar manipulaciones. Los cambios en las propiedades del archivo, como su firma digital, pueden indicar alteraciones sospechosas.

- Regulaciones y legislación: implementar leyes que penalicen la creación y difusión de deepfakes malintencionados. La colaboración internacional es crucial para crear un marco legal que permita perseguir a los creadores de deepfakes independientemente de su ubicación geográfica.

- Alianzas entre plataformas de redes sociales y empresas tecnológicas: las plataformas como Facebook, Twitter, y YouTube pueden desarrollar y compartir tecnologías de detección con gobiernos y otras organizaciones para eliminar rápidamente contenido falso. Además, estas plataformas pueden marcar o eliminar contenido sospechoso de ser un deepfake, alertando a los usuarios.

En conclusión, esta nueva práctica de la IA representa una amenaza en expansión, especialmente cuando cae en manos de ciberdelincuentes, y cada vez se le debe de prestar una mayor atención, mediante el desarrollo de herramientas de detección más avanzadas y un compromiso constante con la educación y la ética. La colaboración entre gobiernos, empresas y ciudadanía apunta a ser la mayor solución para reducir estos peligros y asegurar que esta nueva tecnología se aplique de manera positiva.